NVIDIA NeMo Framework

Mga detalye

- Ngalan sa Produkto: NVIDIA NeMo Framework

- Naapektuhan nga mga Platform: Windows, Linux, macOS

- Naapektuhan nga mga Bersyon: Ang tanan nga mga bersyon sa wala pa ang 24

- Pagkahuyang sa Seguridad: CVE-2025-23360

- Risk Assessment Base Score: 7.1 (CVSS v3.1)

Mga Instruksyon sa Paggamit sa Produkto

Pag-instalar sa Pag-update sa Seguridad:

Aron mapanalipdan ang imong sistema, sunda kini nga mga lakang:

- I-download ang pinakabag-o nga pagpagawas gikan sa NeMo-Framework-Launcher Releases page sa GitHub.

- Adto sa NVIDIA Product Security para sa dugang nga impormasyon.

Mga Detalye sa Pag-update sa Seguridad:

Ang pag-update sa seguridad nagtubag sa usa ka kahuyang sa NVIDIA NeMo Framework nga mahimong mosangpot sa pagpatuman sa code ug data tampering

Pag-upgrade sa Software:

Kung naggamit ka usa ka sayo nga pagpagawas sa sanga, girekomenda nga mag-upgrade sa pinakabag-o nga pagpagawas sa sanga aron matubag ang isyu sa seguridad.

Tapos naview

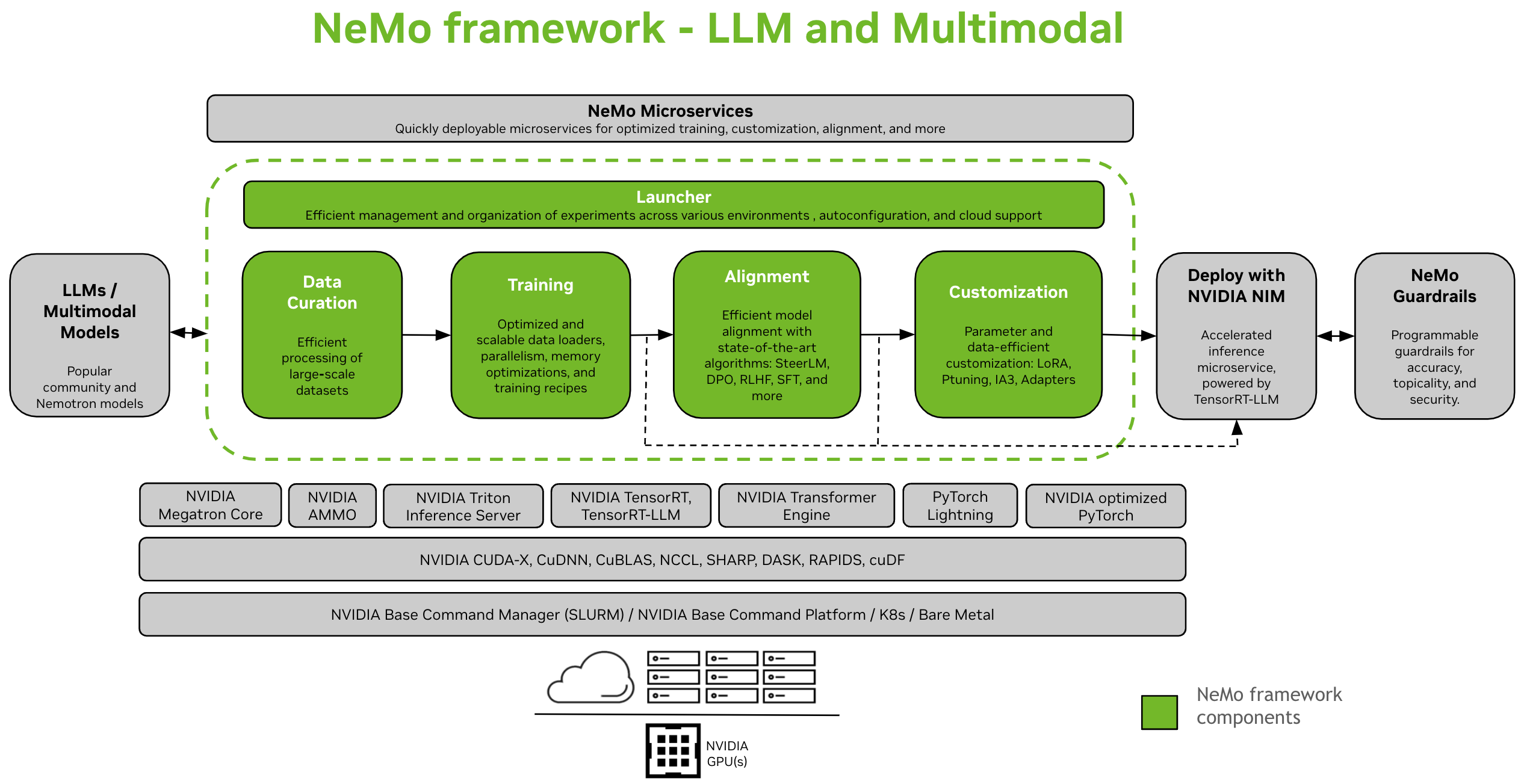

Ang NVIDIA NeMo Framework usa ka scalable ug cloud-native generative AI framework nga gitukod alang sa mga tigdukiduki ug developers nga nagtrabaho sa Dagkong mga Modelo sa Pinulongan, Multimodal, ug Pagsulti AI (eg Awtomatikong Pag-ila sa Pagsulti ug Text-to-Speech). Gitugotan niini ang mga tiggamit sa paghimo, pag-customize, ug pag-deploy sa mga bag-ong generative AI models pinaagi sa paggamit sa kasamtangan nga code ug pre-trained model checkpoints.

Mga Instruksyon sa Pag-setup: I-install ang NeMo Framework

Ang NeMo Framework naghatag og end-to-end nga suporta alang sa pagpalambo sa Large Language Models (LLMs) ug Multimodal Models (MMs). Naghatag kini sa pagka-flexible nga magamit sa lugar, sa usa ka sentro sa datos, o sa imong gusto nga cloud provider. Gisuportahan usab niini ang pagpatuman sa SLURM o Kubernetes nga mga palibot.

Data Curation

NeMo Curator [1] usa ka librarya sa Python nga naglakip sa usa ka suite sa mga modules alang sa data mining ug synthetic data generation. Sila scalable ug na-optimize alang sa mga GPU, nga naghimo kanila nga sulundon alang sa pag-curate sa natural nga data sa pinulongan aron sa pagbansay o pag-ayo sa mga LLM. Uban sa NeMo Curator, mahimo nimong makuha ang taas nga kalidad nga teksto gikan sa daghang hilaw web tinubdan sa datos.

Pagbansay ug Pag-customize

Ang NeMo Framework naghatag mga himan alang sa episyente nga pagbansay ug pag-customize sa Mga LLM ug Multimodal nga mga modelo. Naglakip kini sa mga default nga mga pag-configure alang sa pag-setup sa cluster sa pagkalkula, pag-download sa datos, ug mga hyperparameter sa modelo, nga mahimong i-adjust aron mabansay ang mga bag-ong dataset ug modelo. Dugang pa sa pre-training, gisuportahan sa NeMo ang duha nga Supervised Fine-Tuning (SFT) ug Parameter Efficient Fine-Tuning (PEFT) nga mga teknik sama sa LoRA, Ptuning, ug uban pa.

Duha ka kapilian ang magamit sa paglansad sa pagbansay sa NeMo - gamit ang interface sa NeMo 2.0 API o sa NeMo Run.

- Uban sa NeMo Run (Girekomenda): Naghatag ang NeMo Run og interface aron ma-streamline ang configuration, execution ug pagdumala sa mga eksperimento sa nagkalain-laing compute environment. Naglakip kini sa paglansad og mga trabaho sa imong workstation sa lokal o sa dagkong mga cluster - pareho nga SLURM nga gipagana o Kubernetes sa usa ka cloud environment.

- Pre-training & PEFT Quickstart sa NeMo Run

- Gamit ang NeMo 2.0 API: Maayo kini nga pamaagi sa usa ka yano nga setup nga naglambigit sa gagmay nga mga modelo, o kung interesado ka sa pagsulat sa imong kaugalingon nga kostumbre nga dataloader, mga loop sa pagbansay, o pagbag-o sa mga layer sa modelo. Naghatag kini kanimo og dugang nga pagka-flexible ug pagkontrol sa mga pag-configure, ug gipasayon ang pag-extend ug pag-customize sa mga configuration sa programmatically.

-

Si Training Quickstart sa NeMo 2.0 API

-

Pagbalhin gikan sa NeMo 1.0 ngadto sa NeMo 2.0 API

-

Pag-align

- NeMo-Aligner [1] usa ka scalable toolkit alang sa episyente nga pag-align sa modelo. Ang toolkit adunay suporta alang sa state-of-the-art nga model alignment algorithms sama sa SteerLM, DPO, Reinforcement Learning from Human Feedback (RLHF), ug daghan pa. Kini nga mga algorithm makapahimo sa mga tiggamit sa pag-align sa mga modelo sa pinulongan aron mahimong mas luwas, dili makadaot, ug makatabang.

- Ang tanan nga NeMo-Aligner checkpoints kay cross-compatible sa NeMo ecosystem, nga nagtugot sa dugang nga pag-customize ug inference deployment.

Step-by-step workflow sa tanang tulo ka hugna sa RLHF sa gamay nga GPT-2B nga modelo:

- Pagbansay sa SFT

- Pagbansay sa modelo sa ganti

- Pagbansay sa PPO

Dugang pa, gipakita namon ang suporta alang sa lainlaing uban pang mga pamaagi sa pag-align sa nobela:

- DPO: usa ka lightweight alignment algorithm kumpara sa RLHF nga adunay mas simple nga pagkawala function.

- Pagdula sa Kaugalingon Fine-Tuning (SPIN)

- SteerLM: usa ka teknik base sa conditioned-SFT, uban sa steerable output.

Tan-awa ang dokumentasyon para sa dugang nga impormasyon: Dokumentasyon sa Pag-align

Multimodal nga mga Modelo

- Ang NeMo Framework naghatag og optimized nga software aron sa pagbansay ug pag-deploy sa state-of-the-art nga multimodal nga mga modelo sa daghang mga kategorya: Multimodal Language Models, Vision-Language Foundations, Text-to-Image nga mga modelo, ug labaw pa sa 2D Generation gamit ang Neural Radiance Fields (NeRF).

- Ang matag kategorya gilaraw aron mahatagan ang piho nga mga panginahanglanon ug pag-uswag sa natad, nga gigamit ang mga modelo sa pagputol aron madumala ang usa ka halapad nga klase sa data, lakip ang teksto, mga imahe, ug mga modelo sa 3D.

Nota

Nagbalhin kami og suporta alang sa multimodal nga mga modelo gikan sa NeMo 1.0 ngadto sa NeMo 2.0. Kung gusto nimong susihon kini nga domain sa kasamtangan, palihug tan-awa ang dokumentasyon alang sa NeMo 24.07 (kaniadto) nga pagpagawas.

Deployment ug Inference

Naghatag ang NeMo Framework og lain-laing mga agianan alang sa LLM inference, nga nagsilbi sa lainlaing mga senaryo sa pag-deploy ug mga panginahanglanon sa pasundayag.

I-deploy gamit ang NVIDIA NIM

- Ang NeMo Framework hapsay nga nag-uban sa mga gamit sa pag-deploy sa modelo sa lebel sa negosyo pinaagi sa NVIDIA NIM. Kini nga panagsama gipadagan sa NVIDIA TensorRT-LLM, nga nagsiguro nga ma-optimize ug masukod ang inference.

- Alang sa dugang nga impormasyon sa NIM, bisitaha ang NVIDIA website.

I-deploy gamit ang TensorRT-LLM o vLLM

- Nagtanyag ang NeMo Framework og mga script ug mga API aron ma-export ang mga modelo sa duha nga na-optimize nga librarya sa inference, TensorRT-LLM ug vLLM, ug i-deploy ang na-export nga modelo sa NVIDIA Triton Inference Server.

- Para sa mga senaryo nga nanginahanglan og optimized performance, ang NeMo nga mga modelo makagamit sa TensorRT-LLM, usa ka espesyal nga library para sa pagpadali ug pag-optimize sa LLM inference sa NVIDIA GPUs. Kini nga proseso naglakip sa pag-convert sa NeMo nga mga modelo ngadto sa usa ka format nga compatible sa TensorRT-LLM gamit ang nemo.export module.

- LLM Deployment Tapos naview

- I-deploy ang NeMo nga Dagkong mga Modelo sa Pinulongan nga adunay NIM

- I-deploy ang NeMo nga Dagkong mga Modelo sa Pinulongan gamit ang TensorRT-LLM

- I-deploy ang NeMo Large Language Models nga adunay vLLM

Gisuportahan nga mga Modelo

Dagkong mga Modelo sa Pinulongan

| Dagkong mga Modelo sa Pinulongan | Pretraining & SFT | PEFT | Pag-align | FP8 Training Convergence | TRT/TRTLLM | Convert Ngadto ug Gikan sa Paggakos sa Nawong | Ebalwasyon |

|---|---|---|---|---|---|---|---|

| Llama3 8B/70B, Llama3.1 405B | Oo | Oo | x | Oo (partially verified) | Oo | Ang duha | Oo |

| Mixtral 8x7B/8x22B | Oo | Oo | x | Oo (wala mapamatud-an) | Oo | Ang duha | Oo |

| Nemotron 3 8B | Oo | x | x | Oo (wala mapamatud-an) | x | Ang duha | Oo |

| Nemotron 4 340B | Oo | x | x | Oo (wala mapamatud-an) | x | Ang duha | Oo |

| Baichuan2 7B | Oo | Oo | x | Oo (wala mapamatud-an) | x | Ang duha | Oo |

| ChatGLM3 6B | Oo | Oo | x | Oo (wala mapamatud-an) | x | Ang duha | Oo |

| Gemma 2B/7B | Oo | Oo | x | Oo (wala mapamatud-an) | Oo | Ang duha | Oo |

| Gemma2 2B/9B/27B | Oo | Oo | x | Oo (wala mapamatud-an) | x | Ang duha | Oo |

| Mamba2 130M/370M/780M/1.3B/2.7B/8B/ Hybrid-8B | Oo | Oo | x | Oo (wala mapamatud-an) | x | x | Oo |

| Phi3 mini 4k | x | Oo | x | Oo (wala mapamatud-an) | x | x | x |

| Qwen2 0.5B/1.5B/7B/72B | Oo | Oo | x | Oo (wala mapamatud-an) | Oo | Ang duha | Oo |

| StarCoder 15B | Oo | Oo | x | Oo (wala mapamatud-an) | Oo | Ang duha | Oo |

| StarCoder2 3B/7B/15B | Oo | Oo | x | Oo (wala mapamatud-an) | Oo | Ang duha | Oo |

| BERT 110M/340M | Oo | Oo | x | Oo (wala mapamatud-an) | x | Ang duha | x |

| T5 220M/3B/11B | Oo | Oo | x | x | x | x | x |

Mga Modelo sa Pinulongan sa Panan-awon

| Mga Modelo sa Pinulongan sa Panan-awon | Pretraining & SFT | PEFT | Pag-align | FP8 Training Convergence | TRT/TRTLLM | Convert Ngadto ug Gikan sa Paggakos sa Nawong | Ebalwasyon |

|---|---|---|---|---|---|---|---|

| NeVA (LLaVA 1.5) | Oo | Oo | x | Oo (wala mapamatud-an) | x | gikan sa | x |

| Llama 3.2 Panan-awon 11B/90B | Oo | Oo | x | Oo (wala mapamatud-an) | x | gikan sa | x |

| LLaVA Sunod (LLaVA 1.6) | Oo | Oo | x | Oo (wala mapamatud-an) | x | gikan sa | x |

Pag-embed sa mga Modelo

| Pag-embed sa mga Modelo sa Pinulongan | Pretraining & SFT | PEFT | Pag-align | FP8 Training Convergence | TRT/TRTLLM | Convert Ngadto ug Gikan sa Paggakos sa Nawong | Ebalwasyon |

|---|---|---|---|---|---|---|---|

| SBERT 340M | Oo | x | x | Oo (wala mapamatud-an) | x | Ang duha | x |

| Llama 3.2 Pag-embed sa 1B | Oo | x | x | Oo (wala mapamatud-an) | x | Ang duha | x |

Mga Modelo sa World Foundation

| Mga Modelo sa World Foundation | Human sa Pagbansay | Gipadali nga Inference |

|---|---|---|

| Cosmos-1.0-Diffusion-Text2World-7B | Oo | Oo |

| Cosmos-1.0-Diffusion-Text2World-14B | Oo | Oo |

| Cosmos-1.0-Diffusion-Video2World-7B | Hapit na | Hapit na |

| Cosmos-1.0-Diffusion-Video2World-14B | Hapit na | Hapit na |

| Cosmos-1.0-Autoregressive-4B | Oo | Oo |

| Cosmos-1.0-Autoregressive-Video2World-5B | Hapit na | Hapit na |

| Cosmos-1.0-Autoregressive-12B | Oo | Oo |

| Cosmos-1.0-Autoregressive-Video2World-13B | Hapit na | Hapit na |

Nota

Gisuportahan usab sa NeMo ang pretraining alang sa parehas nga pagsabwag ug autoregressive nga mga arkitektura text2world mga modelo sa pundasyon.

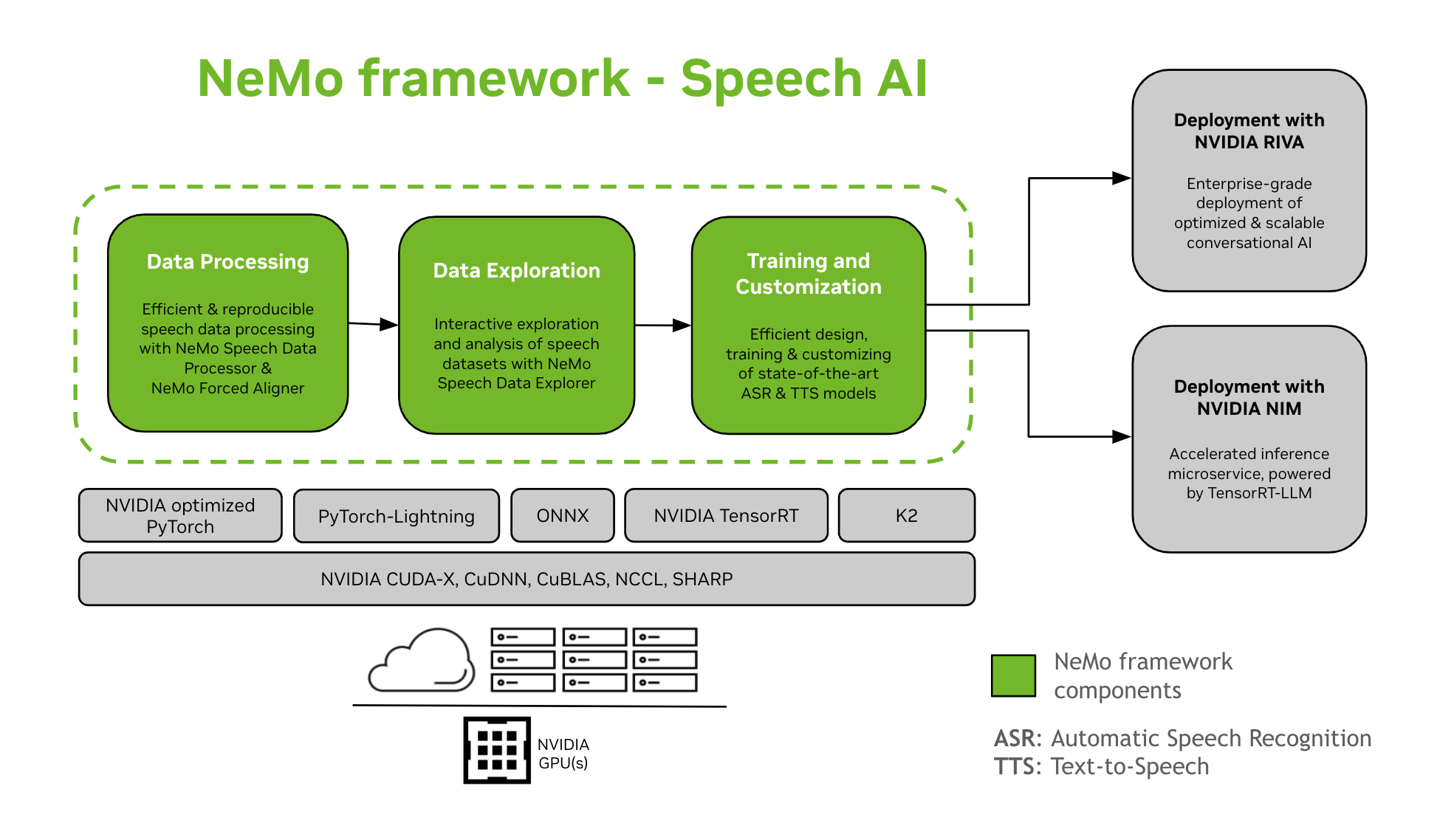

Pagsulti AI

Ang pag-develop sa mga modelo sa AI nga panag-istoryahanay usa ka komplikado nga proseso nga naglakip sa pagtino, pagtukod, ug mga modelo sa pagbansay sulod sa partikular nga mga dominyo. Kini nga proseso kasagaran nanginahanglan daghang mga pag-uli aron maabot ang taas nga lebel sa katukma. Kanunay kini nga naglambigit sa daghang mga pag-ulit aron makab-ot ang taas nga katukma, pag-ayo sa lainlaing mga buluhaton ug datos nga piho sa domain, pagsiguro nga pasundayag sa pagbansay, ug pag-andam sa mga modelo alang sa pag-deploy sa inference.

Ang NeMo Framework naghatag suporta alang sa pagbansay ug pag-customize sa mga modelo sa Speech AI. Naglakip kini sa mga buluhaton sama sa Automatic Speech Recognition (ASR) ug Text-To-Speech (TTS) synthesis. Nagtanyag kini usa ka hapsay nga pagbalhin sa lebel sa produksiyon sa negosyo sa NVIDIA Riva. Aron matabangan ang mga developer ug tigdukiduki, ang NeMo Framework naglakip sa state-of-the-art nga pre-trained checkpoints, mga himan alang sa reproducible speech data processing, ug mga feature para sa interactive nga eksplorasyon ug pagtuki sa mga dataset sa speech. Ang mga sangkap sa NeMo Framework alang sa Speech AI mao ang mosunod:

Pagbansay ug Pag-customize

Ang NeMo Framework naglangkob sa tanan nga gikinahanglan sa pagbansay ug pagpahiangay sa mga modelo sa pagsulti (ASR, Klasipikasyon sa Pagsulti, Pag-ila sa Speaker, Speaker Diarization, ug TTS) sa usa ka reproducible nga paagi.

SOTA Pre-trained nga mga Modelo

- Naghatag ang NeMo Framework sa labing bag-o nga mga resipe ug nabansay nang daan nga mga checkpoint sa daghang ASR ug TTS mga modelo, ingon man mga panudlo kung giunsa kini i-load.

- Mga Himan sa Pagsulti

- Ang NeMo Framework naghatag usa ka hugpong sa mga himan nga mapuslanon alang sa pagpalambo sa mga modelo sa ASR ug TTS, lakip ang:

- NeMo Forced Aligner (NFA) alang sa pagmugna og token-, pulong- ug segment-level timestamps sa pagsulti sa audio gamit ang mga modelo sa Automatic Speech Recognition nga nakabase sa CTC sa NeMo.

- Speech Data Processor (SDP), usa ka toolkit alang sa pagpayano sa pagproseso sa datos sa pagsulti. Gitugotan ka niini nga magrepresentar sa mga operasyon sa pagproseso sa datos sa usa ka config file, pagminus sa boilerplate code ug pagtugot sa reproducibility ug shareability.

- Speech Data Explorer (SDE), usa ka Dash-based web aplikasyon alang sa interactive nga eksplorasyon ug pagtuki sa mga dataset sa pagsulti.

- Himan sa paghimo sa Dataset nga naghatag pagpaandar aron ipahiangay ang taas nga audio files uban sa katugbang nga mga transcript ug gibahin kini sa mas mugbo nga mga tipik nga angay alang sa pagbansay sa modelo sa Automatic Speech Recognition (ASR).

- Himan sa Pagtandi alang sa ASR Models aron itandi ang mga panagna sa lain-laing mga modelo sa ASR sa katukma sa pulong ug lebel sa paglitok.

- ASR Evaluator para sa pag-evaluate sa performance sa mga modelo sa ASR ug uban pang feature sama sa Voice Activity Detection.

- Tool sa Pag-normalize sa Teksto alang sa pag-convert sa teksto gikan sa sinulat nga porma ngadto sa gipamulong nga porma ug vice versa (eg “ika-31” batok sa “katloan ka una”).

- Dalan padulong sa Deployment

- Ang mga modelo sa NeMo nga nabansay o na-customize gamit ang NeMo Framework mahimong ma-optimize ug ma-deploy sa NVIDIA Riva. Naghatag ang Riva og mga sudlanan ug mga tsart sa Helm nga espesipikong gidisenyo aron ma-automate ang mga lakang alang sa pag-deploy sa push-button.

Ubang mga Kapanguhaan

- NeMo: Ang nag-unang repository alang sa NeMo Framework

- NeMo–Dagan: Usa ka himan sa pag-configure, paglansad ug pagdumala sa imong mga eksperimento sa pagkat-on sa makina.

- NeMo-Aligner: Scalable toolkit para sa episyente nga pag-align sa modelo

- NeMo-Curator: Scalable data pre-processing ug curation toolkit para sa LLMs

Pakig-apil sa komunidad sa NeMo, pagpangutana, pagkuha og suporta, o pagreport sa mga bug.

- Mga Panaghisgot sa NeMo

- Mga Isyu sa NeMo

Mga Pinulongan ug Framework sa Programming

- Python: Ang nag-unang interface sa paggamit sa NeMo Framework

- Pytorch: Ang NeMo Framework gitukod sa ibabaw sa PyTorch

Mga lisensya

- Ang NeMo Github repo lisensyado ubos sa Apache 2.0 nga lisensya

- Ang NeMo Framework lisensyado ubos sa NVIDIA AI PRODUCT AGREEMENT. Pinaagi sa pagbira ug paggamit sa sudlanan, imong gidawat ang mga termino ug kondisyon niini nga lisensya.

- Ang sudlanan sa NeMo Framework adunay Llama nga mga materyales nga gidumala sa Meta Llama3 Community License Agreement.

Mga footnote

Sa pagkakaron, ang NeMo Curator ug NeMo Aligner nga suporta alang sa Multimodal nga mga modelo usa ka trabaho sa pag-uswag ug mahimong magamit sa dili madugay.

FAQ

P: Unsaon nako pagsusi kung ang akong sistema naapektuhan sa pagkahuyang?

A: Mahimo nimong susihon kung naapektuhan ang imong sistema pinaagi sa pag-verify sa bersyon sa NVIDIA NeMo Framework nga na-install. Kung kini ubos sa bersyon 24, ang imong sistema mahimong mahuyang.

P: Kinsa ang nagtaho sa isyu sa seguridad CVE-2025-23360?

A: Ang isyu sa seguridad gitaho ni Or Peles - JFrog Security. Giila sa NVIDIA ang ilang kontribusyon.

P: Unsaon nako pagdawat sa umaabot nga mga abiso sa bulletin sa seguridad?

A: Bisitaha ang panid sa NVIDIA Product Security aron mag-subscribe sa mga abiso sa bulletin sa seguridad ug magpabilin nga nahibal-an bahin sa mga update sa seguridad sa produkto.

Mga Dokumento / Mga Kapanguhaan

|

NVIDIA NeMo Framework [pdf] Giya sa Gumagamit NeMo Framework, NeMo, Framework |